用事后视角自动评分十年前的 Hacker News 讨论

TLDR: https://karpathy.ai/hncapsule/

昨天我偶然刷到这条 HN 讨论:Show HN: Gemini Pro 3 hallucinates the HN front page 10 years from now,Gemini 3 在幻觉式地生成 10 年后的首页。不过另一条评论更让我眼前一亮——Bjartr 链接了恰好 10 年前的 HN 首页,也就是 2015 年 12 月。我翻看着十年前的讨论,脑补着它们的先见之明,突然意识到:这事儿让 LLM 来干可能更合适。我把其中一篇文章+评论串手动复制到 ChatGPT 5.1 Thinking 里,它给了我一份漂亮的分析,把人们当时的想法和后来发生的事情对照得清清楚楚,比我手动做得好且详细得多。我意识到这任务很适合 LLM,我正想找个理由用刚发布的 Opus 4.5 来小小狂飙,就开干了。我要抓下整个 12 月的首页(31 天、每天 30 篇文章),让 ChatGPT 5.1 Thinking 做分析,再把结果以舒适的方式呈现,供历史阅读。

我觉得这个练习有两点更普遍的价值:

- 我认为只要有训练和投入,打造一个面向未来的预测器是完全可能且值得的。

- 我再次想起我曾发过的推文:“要行善,未来的 LLM 在看着你。” 你可以从很多角度理解这句话,但这里我想聚焦在“未来的 LLM 确实在看着”这个想法上。我们今天做的一切,未来都可能被细致审视,因为这样做将“免费”。很多人的行为方式隐含一种“靠模糊带来的安全”的假设。但如果智能真的廉价到不计量,就有可能对一切做到完美重建和综合。LLM 在看着(或者是用它们的未来人类在看着)。最好行善。

用 Opus 4.5 进行 vibe coding 实际项目相对顺利,花了大约 3 小时,中间有点小波折,但整体非常惊艳。代码仓库在 GitHub:karpathy/hn-time-capsule。下面是代码功能的演进:

-

给定日期,下载当天首页的 30 篇文章

-

对每篇文章,使用 Algolia API 下载/解析文章本身以及完整的评论串。

-

把所有内容打包成一个请求分析的 markdown prompt。下面是我用的 prompt 前缀:

下面是一篇 10 年前出现在 Hacker News 上的文章及其讨论串。

现在让我们利用事后视角,从 6 个部分展开:

- 简要总结文章和讨论串。

- 这个话题后来发生了什么?(简要检索一下并写个总结)

- 评出“最有先见”与“最离谱”评论奖,结合后来的事实。

- 提到文章或讨论中的其他有趣/值得注意的方面。

- 结合后来的发展,为特定评论者打分。

- 最后给出一个评分(0-10),衡量这篇文章及其事后分析的有趣程度。

第 5 部分的格式,请使用标题“Final grades”,并跟一个无序列表,格式为“name: grade (optional comment)”。例如:

Final grades

- speckx: A+ (excellent predictions on ...)

- tosh: A (correctly predicted this or that ...)

- keepamovin: A

- bgwalter: D

- fsflover: F (completely wrong on ...)

你的列表当然可以包含比这个玩具示例更多的人。请严格遵守该格式,因为我会用程序解析。想法是我会积累每个账号的得分,找出在较长时间内最有先见/最离谱的账号。

第 6 部分的格式,请使用前缀“Article hindsight analysis interestingness score:”,然后是一个数值(0-10)。对于在事后看来显著、重要或有趣的文章/讨论给高分;当几乎没人做预测、话题非常小众、或讨论在事后不太有趣时给低分。

例如: Article hindsight analysis interestingness score: 8

-

将 prompt 提交给 OpenAI API 的 GPT 5.1 Thinking

-

收集并解析结果

-

将结果渲染为静态 HTML 页面以便浏览

-

把 HTML 结果页托管在我的网站上:https://karpathy.ai/hncapsule/

-

托管所有中间结果数据,方便别人玩。它就是同一 url 前缀下的

data.zip文件(刻意不放直链)。

我花了几个小时随便逛了逛,觉得很有意思。下面是一些有趣的示例串:

- 2015 年 12 月 3 日 Swift 开源了。

- 2015 年 12 月 6 日 Figma 发布

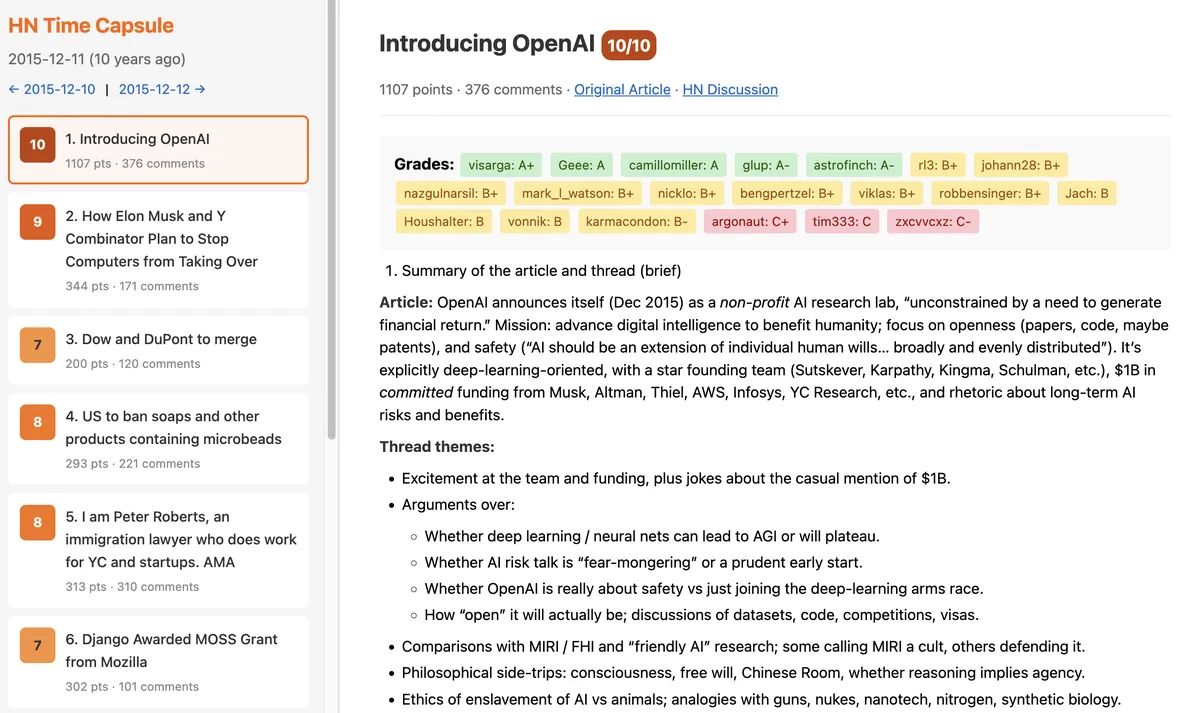

- 2015 年 12 月 11 日 OpenAI 的最初公告 :')。

- 2015 年 12 月 16 日 geohot 在打造 Comma

- 2015 年 12 月 22 日 SpaceX 发射网络直播:Orbcomm-2 任务

- 2015 年 12 月 28 日 Theranos 的挣扎

然后当你点进名人堂,可以看到 2015 年 12 月 Hacker News 的顶级评论者,按 imdb 风格的绩点排序。特别祝贺 pcwalton、tptacek、paulmd、cstross、greglindahl、moxie、hannob、0xcde4c3db、Manishearth、johncolanduoni —— GPT 5.1 Thinking 觉得你们的评论极具洞察力和先见之明。你也可以一直往下翻,找到 HN 的噪声区,我想大家都很熟悉吧 :)

我的代码(等等,是 Opus 的代码?)在 GitHub,可以用来复现或调整结果。让 31 天、每天 30 篇文章跑一遍 GPT 5.1 Thinking 就是 31 * 30 = 930 次 LLM 调用,花了大概 58 美元、约 1 小时。未来的 LLM 大佬们可能会觉得这种事轻轻松松、又快又便宜。